type

status

date

slug

summary

tags

category

icon

password

comments

学不进去基础学习,直接开始整活儿transformer。

1.安装HuggingFace库

2.基础组件Pipeline

2.1 什么是Pipeline

将数据预处理、模型调用、结果后处理三部分组装成的流水线

使我们能够直接输入文本便获得最终的答案

2.2 Pipeline支持的文本类型

镜像网站

https://aifasthub.com点击右侧 “Files and versions”,下载所有核心文件(至少包括:

config.json、pytorch_model.bin、tokenizer_config.json、vocab.txt)

使用模型text-classification功能使用GPU进行推导

确定Pipeline参数

其他Pipeline示例

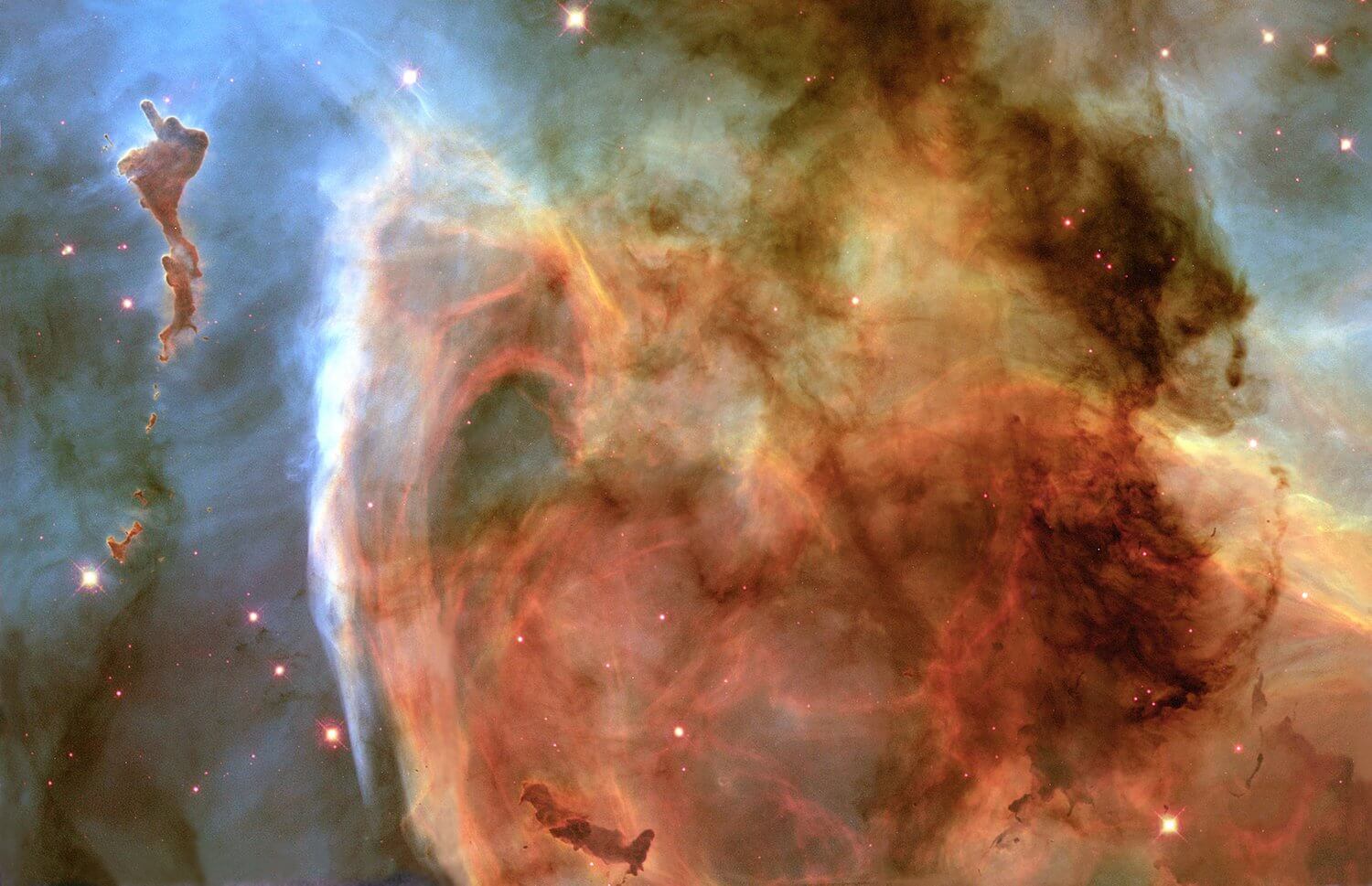

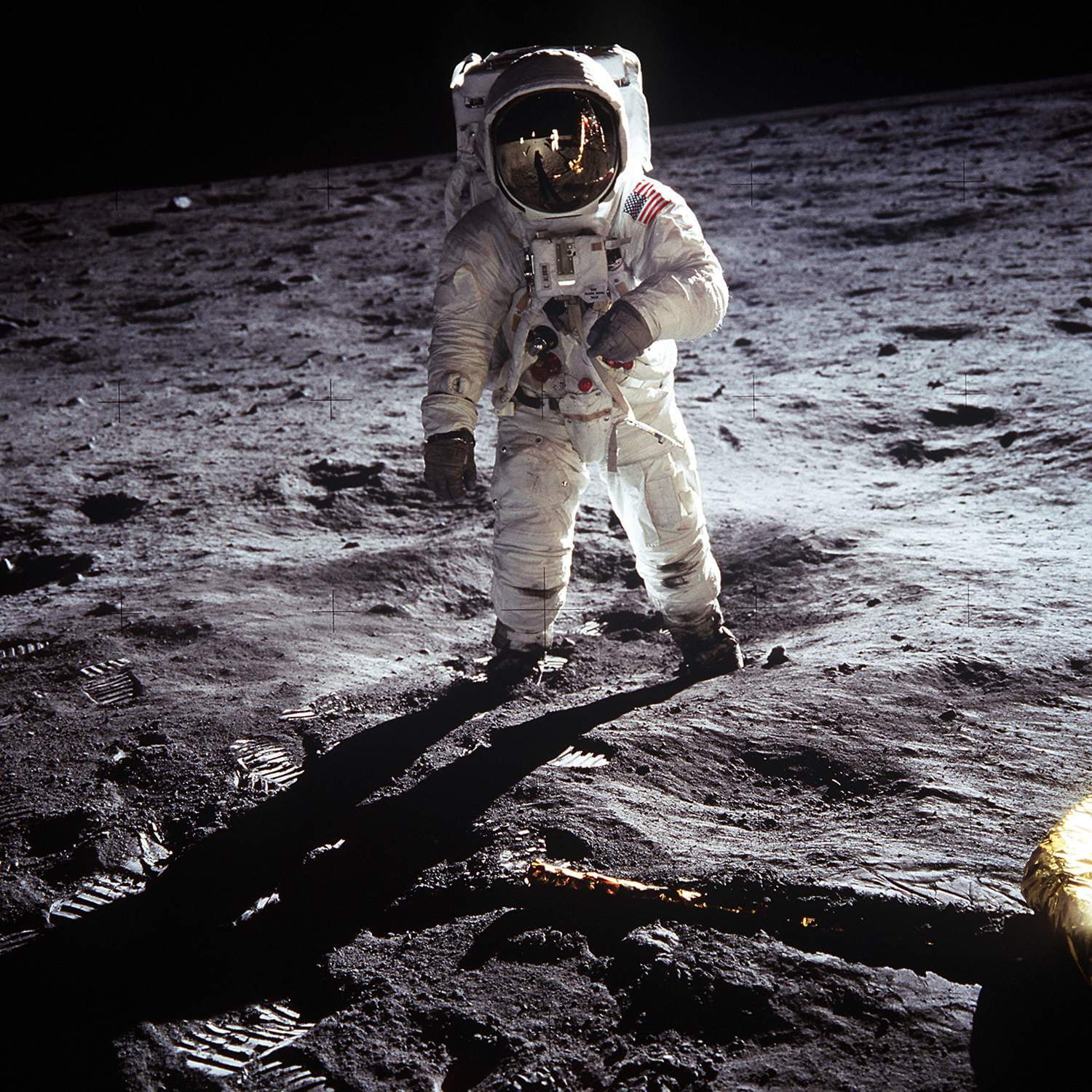

识图

3. Tokenizer

3.1数据预处理

Step1 分词:使用分词器对文本数据进行分词(字、字词);

Step2 构建词典:根据数据集分词的结果,构建词典映射(这一步并不绝对,如果采用预训练词向量,词典映射要根据词向量文件进行处理);

Step3 数据转换:根据构建好的词典,将分词处理后的数据做映射,将文本序列转换为数字序列;

Step4 数据填充与截断:在以batch输入到模型的方式中,需要对过短的数据进行填充,过长的数据进行截断保证数据长度符合模型能接受的范围,同时batch内的数据维度大小一致。

3.2代码实现

Tokenizer基本使用

Step1:加载与保存

Step2:句子分词

Step3:查看词典

Step4:索引转换

更便捷的实现方法

Step5:填充和阶段

Step6:其他输入部分

Step7:快速调用方式

Step8:处理batch数据

3.3Fast/Slow Tokenizer

4. Model

4.1 Model简介

4.1.1 Transformer

原始的Transformer为编码器(Encoder)、解码器(Decoder)模型

Encoder部分接收输入并构建其完整特征表示,Decoder部分使用Encoder的编码结果以及其他的输入生成目标序列

无论是编码器还是解码器,均由多个TransformerBlock堆叠而成

TransformerBlock由注意力机制(Attention)和FFN组成

4.1.2注意力机制

注意力机制的使用是Transformer的一个核心特性,在计算当前词的特征表示时,可以通过注意力机制有选择性的告诉模型要使用哪些上下文

4.2 模型类型

编码器模型:自编码模型,使用Encoder,拥有双向的注意力机制,即计算每一个词的特征时都看到完整上下文

解码器模型:自回归模型,使用Decoder,拥有单向的注意力机制,即计算每一个词的特征时都只能看到上文,无法看到下文

编码器解码器模型:席列到序列模型,使用Encoder+Decoder,Encoder部分使用双向的注意力,Decoder部分使用单向注意力

欢迎您在底部评论区留言,一起交流~

- 作者:于淼

- 链接:https://yumiao1.com/article/26e69159-6c5f-8075-97ab-effc3ef2183e

- 声明:本文采用 CC BY-NC-SA 4.0 许可协议,转载请注明出处。